Reacher¶

此环境是 MuJoCo 环境的一部分,其中包含有关该环境的通用信息。

动作空间 |

|

观测空间 |

|

导入 |

|

描述¶

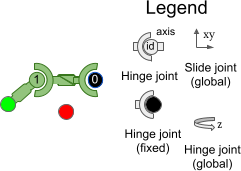

“Reacher”是一个双关节机器人手臂。目标是将机器人的末端执行器(称为*指尖*)移动到随机位置生成的目标附近。

动作空间¶

动作空间是一个 Box(-1, 1, (2,), float32)。动作 (a, b) 表示施加在铰链关节处的扭矩。

序号 |

动作 |

控制最小值 |

控制最大值 |

名称 (在对应的XML文件中) |

关节 |

类型 (单位) |

|---|---|---|---|---|---|---|

0 |

施加在第一个铰链(连接连杆到固定点)的扭矩 |

-1 |

1 |

joint0 |

铰链 |

扭矩 (N m) |

1 |

施加在第二个铰链(连接两个连杆)的扭矩 |

-1 |

1 |

joint1 |

铰链 |

扭矩 (N m) |

观测空间¶

观测空间由以下部分(按顺序)组成

cos(qpos) (2个元素): 两个手臂角度的余弦。

sin(qpos) (2个元素): 两个手臂角度的正弦。

qpos (2个元素): 两个手臂的角度。

qvel (2个元素): 手臂的角速度(它们的导数)。

xpos (2个元素): 目标与 Reacher 之间的向量。

观测空间是一个 Box(-Inf, Inf, (10,), float64),其元素如下所示

序号 |

观测 |

最小值 |

最大值 |

名称 (在对应的XML文件中) |

关节 |

类型 (单位) |

|---|---|---|---|---|---|---|

0 |

第一个手臂角度的余弦 |

-Inf |

Inf |

cos(joint0) |

铰链 |

无单位 |

1 |

第二个手臂角度的余弦 |

-Inf |

Inf |

cos(joint1) |

铰链 |

无单位 |

2 |

第一个手臂角度的正弦 |

-Inf |

Inf |

sin(joint0) |

铰链 |

无单位 |

3 |

第二个手臂角度的正弦 |

-Inf |

Inf |

sin(joint1) |

铰链 |

无单位 |

4 |

目标x坐标 |

-Inf |

Inf |

target_x |

slide |

位置 (m) |

5 |

目标y坐标 |

-Inf |

Inf |

target_y |

slide |

位置 (m) |

6 |

第一个手臂的角速度 |

-Inf |

Inf |

joint0 |

铰链 |

角速度 (rad/s) |

7 |

第二个手臂的角速度 |

-Inf |

Inf |

joint1 |

铰链 |

角速度 (rad/s) |

8 |

指尖位置 - 目标位置 的 x 值 |

-Inf |

Inf |

不适用 |

slide |

位置 (m) |

9 |

指尖位置 - 目标位置 的 y 值 |

-Inf |

Inf |

不适用 |

slide |

位置 (m) |

排除 |

指尖位置 - 目标位置 的 z 值(Reacher 是2D的,所以始终为0) |

-Inf |

Inf |

不适用 |

slide |

位置 (m) |

大多数 Gymnasium 环境仅返回 .xml 文件中关节的位置和速度作为环境状态。然而,在 Reacher 中,状态是通过组合位置和速度的某些元素并对其执行一些函数变换而创建的。reacher.xml 包含这4个关节

序号 |

观测 |

最小值 |

最大值 |

名称 (在对应的XML文件中) |

关节 |

单位 |

|---|---|---|---|---|---|---|

0 |

第一个手臂的角度 |

-Inf |

Inf |

joint0 |

铰链 |

角度 (rad) |

1 |

第二个手臂的角度 |

-Inf |

Inf |

joint1 |

铰链 |

角度 (rad) |

2 |

目标x坐标 |

-Inf |

Inf |

target_x |

slide |

位置 (m) |

3 |

目标y坐标 |

-Inf |

Inf |

target_y |

slide |

位置 (m) |

奖励¶

总奖励为:*奖励* = *距离奖励 + 控制奖励*。

距离奖励: 此奖励衡量 Reacher 的*指尖*(未连接端)与目标的距离,如果 Reacher 的*指尖*离目标越远,则分配一个更负的值。它是 \(-w_{near} \|(P_{fingertip} - P_{target})\|_2\)。其中 \(w_{near}\) 是

reward_near_weight(默认为 \(1\))。控制奖励: 一种负奖励,用于惩罚行走器采取过大动作。它以动作的负欧几里得范数平方衡量,即 \(-w_{control} \|action\|_2^2\)。其中 \(w_{control}\) 是

reward_control_weight。(默认为 \(0.1\))

info 包含各个奖励项。

初始状态¶

Reacher 手臂的初始位置状态为 \(\mathcal{U}_{[-0.1 \times I_{2}, 0.1 \times I_{2}]}\)。目标的永久位置状态为 \(\mathcal{S}(0.2)\)。Reacher 手臂的初始速度状态为 \(\mathcal{U}_{[-0.005 \times 1_{2}, 0.005 \times 1_{2}]}\)。物体的永久速度状态为 \(0_2\)。

其中 \(\mathcal{U}\) 是多元均匀连续分布,\(\mathcal{S}\) 是均匀连续球形分布。

默认帧率为 \(2\),每帧持续 \(0.01\),因此 *dt = 5 * 0.01 = 0.02*。

回合结束¶

终止¶

Reacher 永远不会终止。

截断¶

一个回合的默认持续时间为 50 个时间步。

参数¶

Reacher 提供了一系列参数来修改观测空间、奖励函数、初始状态和终止条件。这些参数可以在 gymnasium.make 期间按以下方式应用

import gymnasium as gym

env = gym.make('Reacher-v5', xml_file=...)

参数 |

类型 |

默认值 |

描述 |

|---|---|---|---|

|

str |

|

MuJoCo 模型的路径 |

|

float |

|

*距离奖励* 项的权重 (参见 |

|

float |

|

*控制奖励* 项的权重 (参见 |

版本历史¶

v5

最低

mujoco版本现在是 2.3.3。增加了

default_camera_config参数,这是一个用于设置mj_camera属性的字典,主要用于自定义环境。增加了

frame_skip参数,用于配置dt(step()的持续时间),默认值因环境而异,请查阅环境文档页面。修复了错误:

距离奖励之前基于物理步之前的状态,现在基于物理步之后的状态(相关 GitHub issue)。从观测空间中移除了

"z - position_fingertip",因为它始终为 0,无法为智能体提供有用信息,这应会使训练略微加快(相关 GitHub issue)。增加了

xml_file参数。增加了

reward_dist_weight、reward_control_weight参数以配置奖励函数(默认值与v4中的基本相同)。修复了

info["reward_ctrl"]未乘以奖励权重的问题。

v4: 所有 MuJoCo 环境现在使用 mujoco >= 2.1.3 中的 MuJoCo 绑定

v3: 此环境没有 v3 版本发布。已移至 gymnasium-robotics 仓库。

v2: 所有连续控制环境现在使用 mujoco-py >= 1.50。已移至 gymnasium-robotics 仓库。

v1: 基于机器人的任务(不包括 Reacher,其最大时间步为 50)的最大时间步提高到 1000。向环境中添加了 reward_threshold。

v0: 初始版本发布